Les dessous d’un concert spatialisé à Radio France

Un concert inédit se déroulera le 10 Juin prochain dans l’Agora de la Maison de la Radio avec au programme, une série de trois live électro en son spatialisé. Dans le prolongement des résidences qu’ils ont effectuées l’année dernière pour la série SEQUENCES, Chloé, NSDOS et Molécule joueront leur set au milieu du public, pour une expérience immersive à 360° dirigée par les ingénieurs du son Hervé Déjardin et Guillaume Le Dû.

Lors de leurs résidences en 2016, les artistes ont composé un morceau en son spatialisé et ce concert représente une nouvelle étape de leur travail. Pour ce live exceptionnel, le défi est le suivant : pendant que les musiciens jouent leur set, les ingénieurs doivent piloter les sons autour de l’artiste et du public. On vous explique comment ça marche.

Comprendre le son multicanal

- De la stéréo à l’octophonie

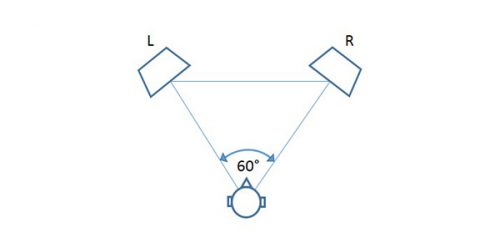

Dans un concert traditionnel en stéréo (2.0), le son est diffusé par deux canaux, sur deux haut-parleurs : un gauche, un droit. On peut alors déplacer le son entre ces haut-parleurs grâce au panoramique.

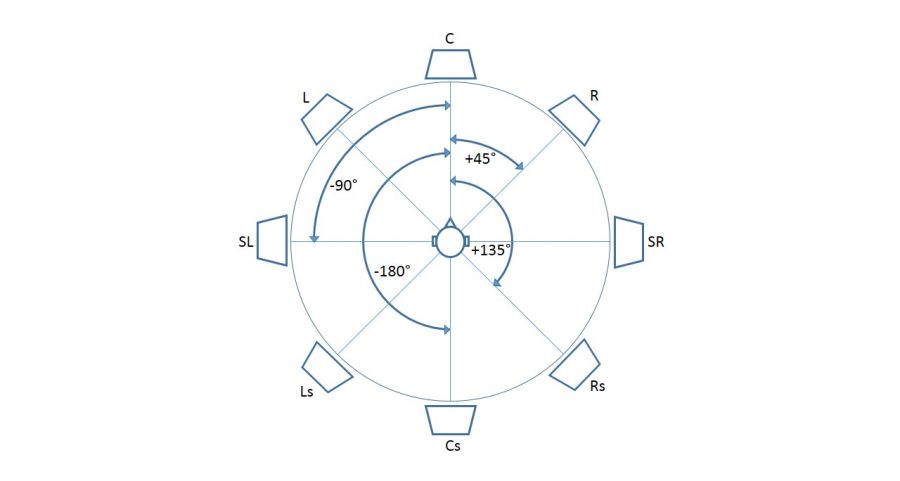

Mais pourquoi se contenter de deux haut-parleurs ? Pourquoi ne pas entourer le public d’enceintes ? C’est ce que permet le son multicanal. Et cela se décline aujourd’hui dans de nombreux formats, les plus célèbres étant le 5.1, le 7.1, ou encore le 22.2. Pour le concert du 10 Juin, il s’agira d’un 8.0, aussi appelé octophonie.

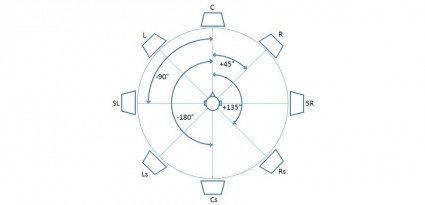

Dans ce 8.0, on a huit canaux diffusés sur une couronne de huit haut-parleurs disposée autour du public. Dans l’idéal, chaque enceinte est séparée des autres selon un angle de 45° autour d’un point central et grâce à cela, on peut promener un son à 360° autour de l’auditeur.

- Et les basses ?

Prenons le 5.1 : 5 enceintes sont disposées autour de l’auditeur, mais il y a aussi un sixième canal dédié aux basses fréquences. C’est le « .1 » qui correspond à ce qu’on appelle le LFE, c’est-à-dire Low Frequency Effect. Le format 5.1 comporte donc 6 canaux. Dans le cas d’un 8.0, nous n’avons que 8 canaux et pas de canal LFE. Cependant, cela n’empêche pas d’ajouter un ou plusieurs haut-parleurs dédiés aux basses fréquences lors de la diffusion, mais ceux-ci seront alors considérés comme des enceintes de « Bass Management », qui joueront les parties basses du spectre que les enceintes principales ne peuvent reproduire, et ne constitueront pas de canal à part entière.

Des outils spéciaux pour ce concert

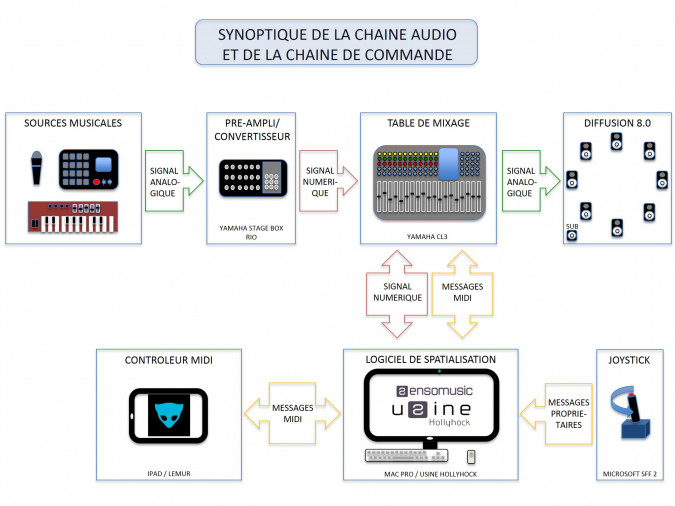

En général à Radio France, lors de la diffusion d’un concert en son 3D, un ingénieur du son s’occupe du mixage des sources sur une table de mixage tandis qu’un autre s’occupe de la spatialisation sur un ordinateur. Pour ce concert, Hervé Déjardin et Guillaume Le Dû ont développé des outils permettant à un seul ingénieur du son d’occuper ces deux postes à la fois.

- Programmer

Les tables de mixage traditionnelles intègrent le panoramique stéréo et parfois les panoramiques 5.1 et 7.1 par le biais d’outils appelés pan-pots. Les pan-pots multicanaux ont la particularité de représenter l’espace de diffusion sonore sur un plan en 2D et permettent à l’utilisateur d’automatiser le mouvement des sources représentées par des points mobiles sur cet espace. Le premier objectif d’Hervé Déjardin et de Guillaume Le Dû a été de développer un pan-pot adapté au 8.0 grâce au logiciel USINE d’Olivier Sens.

Le résultat permet d’automatiser le mouvement de chaque source selon 6 modes de déplacement différents. L’un de ces modes permet par exemple de prêter à un son les caractéristiques d’un corps soumis à la gravité. Un autre permet de déplacer ce son avec un joystick de simulateur de vol !

- Manœuvrer

L’autre objectif des ingénieurs du son a été de transformer une table de mixage en télécommande d’ordinateur, pour contrôler les paramètres spatiaux de façon rapide et pratique. Ainsi, la table de mixage reste une table de mixage, mais elle permet en plus de spatialiser le son de manière intuitive. Par ailleurs, Hervé Déjardin et Guillaume Le Dû ont aussi configuré une deuxième télécommande à partir d’une tablette tactile pour s’affranchir de l’usage de la souris d’ordinateur. Grâce à ce dispositif, l’ingénieur du son n’a plus besoin de changer de poste, que ce soit pour mixer ou pour spatialiser.

La spatialisation, pour quoi faire ?

Il est possible d’employer la spatialisation sonore de manière très démonstrative ou plus subtile. On peut faire tourner un son très vite autour du public pour un effet vertigineux, on peut le faire traverser le public de part en part, mais on peut aussi simplement répartir les sources sonores dans l’espace sans les déplacer.

Tandis que certains sons seront mieux perçus fixes, d’autres se prêteront très bien au mouvement. Presque tout est possible, à condition de ne pas se perdre. C’est pour cela que les ingénieurs du son et les musiciens ont travaillé en amont au studio 105 de la Maison de la Radio pendant deux jours pour s’assurer que la gestion de l’espace respecte l’esthétique de chaque artiste et qu’elle ait un sens musical.

Et en bonus, voici une représentation simplifiée du dispositif :

À lire aussi :

- Le blog de Bergame Périaux, auteur du livre Le Son Multicanal aux éditions Dunod.

- Le site d’Hervé Déjardin, où vous pourrez écouter ses propres compositions en son spatialisé.

- Le site officiel du projet BILI, qui contient de nombreux articles et informations autour du son 3D.

- Un article de Télérama sur les ambitions de NouvOson.

par Jules Négrier